Google, yapay zekâ destekli arama deneyimini genişletmeye devam ediyor. Şirketin AI Modu adını verdiği arama odaklı sohbet robotu artık yalnızca metinleri değil, görselleri de anlayabiliyor. Bu yeni özellik, kullanıcıların görseller üzerinden soru sormalarına ve içerik hakkında kapsamlı yanıtlar almalarına olanak tanıyor. Google, bu güncellemeyi Android ve iOS’ta Google uygulaması üzerinden milyonlarca kullanıcıya açtı.

Güncelleme, Gemini yapay zekâ modelinin özel bir versiyonuyla Google Lens teknolojisinin birleşimini temel alıyor. Kullanıcılar bir fotoğraf çekerek ya da cihazlarından bir görsel yükleyerek yapay zekâya içerik hakkında sorular yöneltebiliyor. Sistem, görseldeki nesneleri tanımakla kalmıyor, onların bağlamlarını da değerlendiriyor. Bu, kullanıcıya yalnızca nesne hakkında bilgi vermek yerine, onu çevreleyen ilişkileri ve görselin genel anlamını da sunuyor.

Google Arama’dan sorumlu ürün yöneticisi Robby Stein, bu güncellemeyi önceki görsel arama çalışmalarının gelişmiş bir evresi olarak tanımlıyor. Yapay zekânın artık şekil, renk, malzeme ve düzen gibi ayrıntıları okuyarak sahnenin tamamını anladığını belirtiyor. Görseldeki her nesne yalnızca ayrı bir varlık olarak değil, birbiriyle ilişkili bir bütün olarak ele alınıyor. Bu da AI Modu’nun kullanıcıya daha doğal ve anlamlı yanıtlar sunmasını sağlıyor.

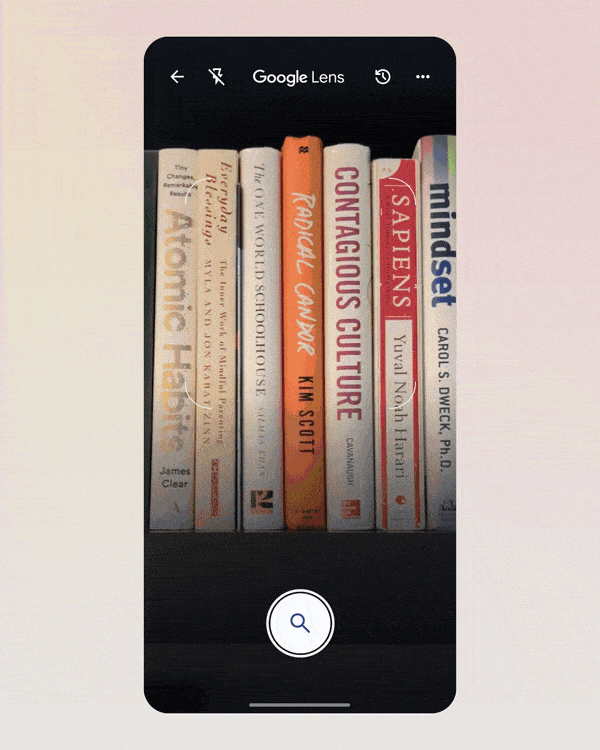

Yapay zekâ, görselleri analiz ederken “fan-out” olarak adlandırılan bir yöntem kullanıyor. Bu yöntemle görseldeki her nesne için çok sayıda paralel sorgu oluşturuluyor. Böylece görseldeki tüm detaylara dair katmanlı ve bağlamsal olarak uyumlu bir cevap ortaya konulabiliyor. Örneğin bir kitaplık fotoğrafı analiz edildiğinde, sistem kitapları tanıyabiliyor, benzer içerikler önerebiliyor ve okuma tavsiyelerinde bulunabiliyor.

Bu gelişme yalnızca görsel tanıma düzeyinde kalmıyor; aynı zamanda kullanıcıyla etkileşime geçerek sorulara da yanıt veriyor. Kullanıcı, görselle ilgili ek bilgi talep ettiğinde, sistem daha fazla sorgu üretip önerilerde bulunabiliyor. Bu, AI Modu’nun statik bir analiz aracı olmaktan çıkarıp, dinamik bir asistan hâline getiriyor. Her görsel, sistem için bilgiye ulaşmak adına bir başlangıç noktası hâline geliyor.

Google, AI Modu’nun ilk kez geçtiğimiz ay Google One AI Premium aboneleri için sınırlı olarak sunmuştu. Ne var ki, güncellemeyle birlikte bu özellik artık sadece ücretli abonelerle sınırlı değil. Şirket, Labs programı kapsamında milyonlarca kullanıcıya erişim sağladığını açıkladı. Bu da daha fazla kişinin gelişmiş görsel arama deneyiminden yararlanabileceği anlamına geliyor.

Tüm bunların yanında, AI Modu’nun bu güncellemeyle birlikte ChatGPT Search ve Perplexity gibi yeni nesil yapay zekâ tabanlı arama çözümleriyle daha doğrudan rekabete girdiği görülüyor. Özellikle kullanıcıların görsel verilerle de etkileşime geçebildiği bu yeni yapı, geleneksel metin odaklı aramaların ötesine geçiyor. Bu durum, kullanıcı deneyimini daha sezgisel ve derinlemesine hâle getiriyor. Yapay zekâya soru sormak artık sadece yazmakla değil, göstermekle de mümkün oluyor.

Bunun yanı sıra, bu teknoloji özellikle alışveriş, eğitim ve içerik keşfi gibi alanlarda önemli avantajlar sağlıyor. Kullanıcılar bir ürünün fotoğrafını çekerek benzer modelleri bulabiliyor ya da bir yapı öğesinin ne olduğunu öğrenebiliyor. Eğitsel içeriklerde ise öğrenciler, karmaşık şemaları veya bilimsel görselleri yapay zekâya analiz ettirerek bilgiye daha hızlı erişebiliyor. Görsel üzerinden öğrenme ve araştırma süreci daha akıcı bir hâl alıyor.

Her ne kadar bu özellik şu an için sadece ABD’deki Labs kullanıcılarına açılmış olsa da, Google’ın bu yetenekleri farklı bölgelere taşımayı planladığı tahmin ediliyor. Şirketin gelecekte bu görsel analiz yeteneğini Google Fotoğraflar, Google Haritalar ve hatta YouTube gibi diğer platformlarla da entegre edebileceği konuşuluyor. Bu tür çok modlu entegrasyonlar, yapay zekâyı sadece metin değil, aynı zamanda görsel merkezli bir platforma dönüştürmeyi hedefliyor. Bu da Google’ın arama deneyimini geleceğe hazırladığını gösteriyor.