Apple perşembe günü iOS, macOS, watchOS ve iMessage’da olası çocuk istismarı görüntülerini tespit edecek yeni teknolojileri kullanıma sunmaya dair planlarını doğruladı, şu anda çalışmaları devam eden projeyle ilgili önemli ayrıntıları açıkladı.

Şirketin belirttiğine göre, ABD’deki cihazlar için, bu sonbaharda kullanıma sunulacak yeni iOS 15 ve iPadOS 15 sürümleri kullanıcı gizliliği için gerekli şartları oluştururken, CSAM’in (çocuk cinsel istismarı ile ilgili materyalin) çevrimiçi yayılmasını sınırlamaya yardımcı olacak yeni şifreleme uygulamalarına sahip olacak.

Proje, Apple’ın web sitesindeki yeni bir “Çocuk Güvenliği” sayfasında da ayrıntılı olarak açıklanıyor. Uygulama kapsamında, bir görüntü iCloud’da yedeklenmeden önce cihaz üzerinde tarama yapılacak. Açıklamaya göre, bir dosya iCloud’a yedeklenene kadar tarama gerçekleşmez ve Apple yalnızca belirli bir hesap için özel şifreleme kuponları (görüntüyle birlikte iCloud’a yüklenir) bilinen CSAM eşiğini karşılarsa eşleşmeyle ilgili verileri alır.

Apple, Gmail ve diğer bulut e-posta sağlayıcılarındaki benzer sistemlere paralel olarak, e-posta üzerinden gönderilen çocuk istismarı görüntülerini taramak için yıllardır karma sistemler kullandı. Duyurusu yeni yapılan program ise, görüntüler başka bir kullanıcıya gönderilmese veya başka şekilde paylaşılmasa bile aynı taramaları iCloud Fotoğrafları’nda depolanan kullanıcı görüntülerine uygulayacak.

Apple’ın konuyla ilgili olarak yayınladığı bir PDF dosyası, gizliliği korumak için dahil edilen çeşitli kısıtlamaları detaylandırıyor ve görüntü tarama hamlelerinindeki haklı olduğunu düşündüğü noktaları dile getiriyor:

Apple, bilinen CSAM veri tabanı ile eşleşmeyen görüntüler hakkında hiçbir şey öğrenmiyor.

Apple, eşleşen CSAM görüntüleri için meta verilere veya görsel türevlere, bir Cloud Fotoğrafları hesabı için eşleşme eşiği aşılmadığı sürece erişmiyor.

Sistemin bir hesabı yanlışlıkla işaretleme riski son derece düşüktür. Ek olarak, Apple, raporlamanın doğru olduğundan emin olmak için NCMEC’e yapılan tüm raporları manuel olarak inceler.

Kullanıcılar, bilinen CSAM görüntülerinin veri tabanına erişemez veya bunları görüntüleyemez.

Kullanıcılar, hangi görüntülerin sistem tarafından CSAM olarak işaretlendiğini belirleyemiyor.

Apple’ın getireceği bu sistemle ilgili ayrıntılar bu haftanın başlarından itibaren internete düşmeye başlamış ve gizlilik konusunda bazı endişelere neden olmuştu. Şirket, böyle bir sistemin gizlilik risklerine karşı koruma sağlaması gereken bir dizi önlem de ekliyor. Özellikle, eşik sistemi, tek başına hataların uyarı oluşturmamasını sağlayarak Apple’ın yılda trilyon kullanıcı başına bir yanlış uyarı hata oranını hedeflemesine olanak tanıyor. Karma sistemi aynı zamanda ABD Ulusal Kayıp ve İstismara Uğramış Çocuklar Merkezi (NCMEC) tarafından işaretlenen materyaller ve iCloud Fotoğraflar’a yüklenen resimlerle sınırlı. Bir uyarı oluşturulduktan sonra, kolluk kuvvetlerini uyarılmadan önce Apple ve NCMEC tarafından incelenecek. Bu da CSAM dışı içeriği tespit etmek için kullanılan sisteme karşı ek bir koruma sağlar.

Apple, sistemin matematiksel olarak sağlam olduğunu ortaya koymak için üç bağımsız şifreleme uzmanından (PDF 1, 2 ve 3) sistemin teknik değerlendirmelerini yapmalarını da istedi. Illinois Üniversitesi bilgisayar bilimleri başkanı Profesör David Forsyth değerlendirmelerden birinde, “Bana göre bu sistem, bu tür resimlere sahip olan veya bu tür resimlerin dağıtımını yapan kişilerin (zararlı kullanıcılar) bulunma olasılığını önemli ölçüde artıracaktır; bu, çocukların korunmasına yardımcı olacaktır,” dedi. “Eşik ile birlikte eşleştirme sisteminin doğruluğu, CSAM resimleri olmadığı bilinmeyen resimlerin ortaya çıkmasını pek olası kılmaz.”

Bununla birlikte Apple, program genişledikçe diğer çocuk güvenlik gruplarının karma kaynaklar olarak eklenebileceğini ve ileriye dönük olarak iş ortaklarının listesini kamuya açık hale getirme taahhüdünde bulunmadığını söyledi.

Apple çocuk istismarı önleme amaçlı ek önlemler de alıyor

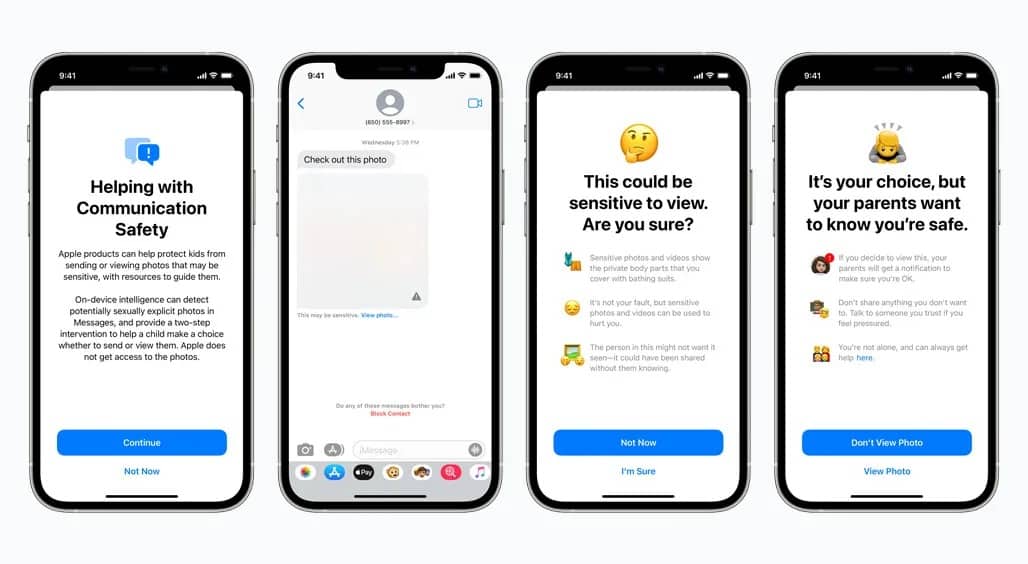

Apple, iCloud Fotoğrafları’ndaki yeni önlemlerin yanı sıra, çocuk istismarı riski altındaki genç iPhone sahiplerini korumak için iki sistem daha ekliyor. Mesajlar uygulaması, potansiyel olarak müstehcen içeriği tespit etmek amacıyla çocuk hesapları için cihazda resim eklerini zaten tarıyordu. Tespit edildiğinde içerik bulanıklaştırılıyor ve bir uyarı gösteriliyor. Ebeveynlerin aile iCloud hesaplarında etkinleştirebilecekleri yeni bir ayar, eğer çocuk algılanan görüntüyü görüntülerse (gelen) veya gönderirse (giden) ebeveynlerinin bu konuda bir mesaj almasını sağlıyor.

Ayrıca Apple Siri ve Arama uygulamasının çocuk istismarı görüntüleri hakkındaki sorgulara verdiği yanıtları da güncelliyor. Yeni sistemde, uygulamalar kullanıcılara bu konuyla ilgilenenlerin zararlı ve sorunlu olduğunu anlatacak ve bu sorunla ilgili yardım almak için iş ortaklarından çeşitli kaynaklar sağlayacak.